Lars und der "ethische Gouverneur" - LARs and the Ethical Governor

Lars war einmal - ehemalige Kinder oder eltere Eltern werden sich erinnern - ein kleiner Eisbär; - jetzt ist er mutiert zu LARs = Lethal Autonomous Robots.

LARs sollen - in Weiterentwicklung der Dronen [MotherboardTV] à la Predator mit Hellfire-Raketen - ihr tödliches Werk ganz ohne menschlichen Einfluss verrichten und dabei 'menschlicher als Menschen' agieren können.

Sehr lesenswert dazu ist Reymer Klüvers Artikel in der Süddeutschen Zeitung vom 14. August: Automaten des Todes. Klüwer zitiert Ronald Arkin,

- einen der weltweit führenden Forscher auf dem Gebiet der Robotik, [der] der Überzeugung [ist], dass es möglich ist, "Roboter zu entwerfen, die weniger Fehler machen, als es jetzt Menschen in Kampfgebieten tun". Die Roboter könnten vielleicht eines Tages so programmiert werden, dass sie nur gemäß Kriegsrecht und den Einsatzregeln von Soldaten handelten. Mit so einem, wie er es nennt, "ethischen Gouverneur" ausgestattete Roboter seien Menschen beim moralischen Abwägen in einer Kampfsituation im Zweifel sogar überlegen, weil sie mehr und schneller als Menschen Informationen verarbeiten könnten. Auch US-Völkerrechtler John McGinnis glaubt, dass mit künstlicher Intelligenz ausgestattete Roboter weniger Zerstörungen anrichten würden und sogar "eine zivilisierende Kraft in Kriegen" sein könnten.

- 1942 formulierte der Science- Fiction-Autor Isaac Asimov in der Kurzgeschichte „Runaround“ drei Grundregeln:

1. Ein Roboter darf einem Menschen durch sein Handeln oder durch Unterlassung keinen Schaden zufügen.

2. Roboter befolgen die Befehle der Menschen, es sei denn, sie stünden im Konflikt mit der ersten Regel.

3. Ein Roboter schützt seine eigene Existenz, es sei denn, das stünde im Konflikt mit Regel eins und/oder zwei.

Das System wirkt zunächst simpel und effektiv, Asimov zeigte aber, dass schon diese drei Regeln miteinander in Konflikt stehen können. In der Geschichte gerät der Roboter „Speedy“, der auf dem Merkur für die Forscher Powell und Donovan für sie lebenswichtiges Selen sammeln soll, in einen Zielkonflikt. Die geologischen Gegebenheiten nahe dem Selenfeld greifen seine Hülle an, er will sich also gemäß Regel drei schützen. Gleichzeitig will er aber gemäß Regel zwei den Befehl ausführen. Da die Faktoren, die die beiden Regeln gewichten, ausbalanciert sind, fährt „Speedy“ im Kreis und bringt dadurch die wartenden Männer in der Raumstation in Gefahr – sie hatten vergessen, dem Roboter einen Dringlichkeitsfaktor einzuprogrammieren. [Wie viel Moral brauchen Maschinen? - Der Tagesspiegel 15.05.2013]

0. Ein Roboter darf die Menschheit nicht verletzen oder durch Passivität zulassen, dass die Menschheit zu Schaden kommt,

weil Algorithmen wohl Regeln, aber nicht die Lösung von Dilemmata abbilden können (vgl. etwa Kohlbergs Theorie der Moralentwicklung). Interesssante Hinweise dazu im Vorwort zu MORAL MACHINES: TEACHING ROBOTS RIGHT FROM WRONG von Wendell Wallach and Colin Allen (2008):

- ... The task of designing AMAs requires a serious look at ethical theory, which originates from a human-centered perspective. The values and concerns expressed in the world’s religious and philosophical traditions are not easily applied to machines. Rule-based ethical systems, for example the Ten Commandments or Asimov’s Three Laws for Robots, might appear somewhat easier to embed in a computer, but as Asimov’s many robot stories show, even three simple rules (later four) can give rise to many ethical dilemmas. Aristotle’s ethics emphasized character over rules: good actions flowed from good character, and the aim of a flourishing human being was to develop a virtuous character. It is, of course, hard enough for humans to develop their own virtues, let alone developing appropriate virtues for computers or robots. Facing the engineering challenge entailed in going from Aristotle to Asimov and beyond will require looking at the origins of human morality as viewed in the fields of evolution, learning and development, neuropsychology, and philosophy.

Machine morality is just as much about human decision making as about the philosophical and practical issues of implementing AMAs. Reflection about and experimentation in building AMAs forces one to think deeply about how humans function, which human abilities can be implemented in the machines humans design, and what characteristics truly distinguish humans from animals or from new forms of intelligence that humans create. Just as AI has stimulated new lines of enquiry in the philosophy of mind, machine morality has the potential to stimulate new lines of enquiry in ethics. Robotics and AI laboratories could become experimental centers for testing theories of moral decision making in artificial systems.

Three questions emerge naturally from the discussion so far. Does the world need AMAs? Do people want computers making moral decisions? And if people believe that computers making moral decisions are necessary or inevitable, how should engineers and philosophers proceed to design AMAs?

Die Frage lässt sich zunächst nur im Hinblick darauf beantworten, wie der engineer den ethical governor designed hat:

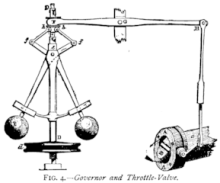

Die Frage lässt sich zunächst nur im Hinblick darauf beantworten, wie der engineer den ethical governor designed hat: “The term governor is inspired by Watts’ invention of the mechanical governor for the steam engine, a device that was intended to ensure that the mechanism behaved safely and within predefined bounds of performance. As the reactive component of a behavioural architecture is in essence a behavioural engine intended for robotic performance, the same notion applies, where here the performance bounds are ethical ones.” (Arkin, 2007, Quelle: s.u.: Matthias)

Wir sind also bei Watts Fliehkraftregler von 1788 (Centrifugal governor) als dem Modell, dem der Ethikregler nachgebaut ist.

So sieht er denn auch aus:

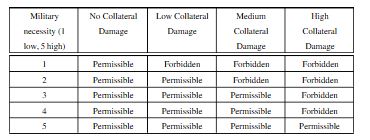

The governor “is a transformer/suppressor of system-generated lethal action to ensurethat it constitutes an ethically permissible action, either nonlethal or obligated ethica llethal force” (Arkin et al., 2009, 1). Technically, the ethical governor is a constraint-driven system, which, on the basis of predicate and deontic logic, tries to evaluate anaction, which has in a previous step been proposed by the tactical reasoning subsystems of the machine, by satisfying various sets of constraints, such as C forbidden, C obligate and so on. Every constraint is a data structure which has a type (e.g. “prohibition”), an origin (“laws of war”), and a logical form (“TargetDiscriminated AND TargetWithinProximityOfCulturalLandmark”) among other fields (Arkin et al., 2009). Among other aims, the ethical governor is supposed to ensure the proportionality of a military response. Interestingly, the “acceptable” level of collateral damage is defined solely as a function of the military necessity of an action: (Quelle: s.u.: Matthias)

Moralisches Abwägen in einer Kampfsituation ist hier nicht erkennbar und der "ethische Gouverneur" entpuppt sich so erst einmal als fataler Übersetzungsfehler und dann als schönes Beispiel für Arschdenk. Fatal ist der Übersetzungsfehler, weil die Metapher "Gouverneur" an autonomes Handeln, Souveränität o. ä. denken lässt (ursprünglich vom griechischen Wort kybernétes (κυβερνήτης „Steuermann“), von dem auch Kybernetik und engl. cyber kommen. Dem Wortsinn nach ist ein Gouverneur somit jemand, der die Richtung vorgibt), und im Zusammenspiel mit dem Attribut ethisch die Vorstellung eines Über-Ich evozieren mag, wo doch nur ein simpler if->then-Regler in die Killerautomaten eingebaut werden soll, der irgendwie an Jamie Shea erinnert.

- Governor (disambiguation) Wir sind hier in technology:

- Governor (device), a device that regulates the speed of a machine

- Centrifugal governor, a type of governor that regulates fuel intake to an engine

- The Governor, an application monitoring Blizzard game's Warden client

und nicht in leadership!

Andreas Matthias: Is the Concept of an Ethical Governor Philosophically Sound? (“Technologies on the stand: legal and ethical questions in neuroscience and robotics”, Tilburg University, Netherlands, April 11-12, 2011)

Im Übrigen:

Setzen Sie in Arkins Matritze in der 1. Spalte für "Military Necessity" probeweise "Financial Markets' Necessities" oder auch nur "Notwendigkeiten zur Euro-Rettung" ein, dann haben Sie die behavioural architecture des Handelns der Bundesregierung erfasst und bemerkt, dass sich das auf den Moralstufen 1 und 2 bewegt, - wenn überhaupt ....

Siehe unten: Moral:

- „Kurz, also was Moral heute vielleicht überhaupt noch heißen darf, das geht über an die Frage nach der Einrichtung der Welt – man könnte sagen: die Frage nach dem richtigen Leben wäre die Frage nach der richtigen Politik, wenn eine solche richtige Politik selber heute im Bereich des zu Verwirklichenden gelegen wäre.“ (Th. W. Adorno, Probleme der Moralphilosophie. Vorlesungen 1963)

Heribert Prantl: Deutschland, ein Tatort

Was bedeutet das Dirigieren der US-Exekutions-Drohnen von Deutschland aus? Entweder die Bundesrepublik ist nicht wirklich souverän – dann ist sie arm dran. Oder Deutschland ist ein williger Helfer bei Straftaten und Menschenrechtsverletzungen. Dann machen sich die Regierenden strafbar…

Via Drohnendesaster und Fähigkeitslücke für zivilen Aufbau. Oder: Mach mir den Immelmann-Turn (II): Rot-grünes Drohnenkonzept

Siehe aber auch:

Projektionsfläche Amerika - Was der deutschlandweit grassierende Antiamerikanismus über die Zustände in der machtpolitisch aufstrebenden Bundesrepublik verrät - Tomasz Konicz tp 21.08.2013:

Je größer die Ähnlichkeit zwischen der Bundesrepublik und den USA, desto stärker schäumt hierzulande der Antiamerikanismus hoch

gebattmer - 2013/08/15 21:00

Trackback URL:

https://gebattmer.twoday.net/stories/453141718/modTrackback